Los científicos del Laboratorio Nacional Lawrence Livermore (LLNL) han ayudado a desarrollar un sistema avanzado de predicción de tsunamis en tiempo real (utilizado por El Capitán, la supercomputadora más rápida del mundo) que podría mejorar drásticamente las capacidades de alerta temprana para las comunidades costeras cercanas a zonas sísmicas.

por el Laboratorio Nacional Lawrence Livermore

El Capitan, a exaescala, con un rendimiento máximo teórico de 2,79 trillones de cálculos por segundo, fue desarrollado en la Administración Nacional de Seguridad Nuclear (NNSA). Como se describe en un artículo preimpreso, finalista del Premio Gordon Bell de la ACM de 2025, los investigadores del LLNL aprovecharon al máximo la potencia de cálculo de la máquina en un único paso de precomputación sin conexión, antes de la transición del sistema a tareas clasificadas de seguridad nacional. El objetivo: generar una inmensa biblioteca de simulaciones basadas en la física, que vinculen el movimiento del fondo marino inducido por terremotos con las olas de tsunami resultantes .

El artículo está publicado en el servidor de preimpresiones arXiv .

El proyecto utilizó más de 43.500 unidades de procesamiento acelerado (APU) AMD Instinct MI300A para resolver problemas de propagación de ondas acústicas-gravitacionales de escala extrema, produciendo un rico conjunto de datos que permite la predicción de tsunamis en tiempo real en sistemas mucho más pequeños.

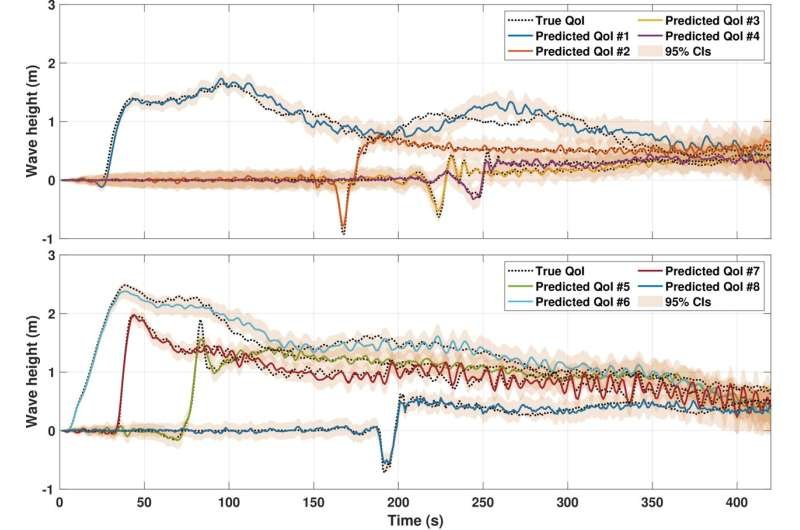

Al anticipar el trabajo computacional intensivo en El Capitán, el equipo logró resolver un problema inverso bayesiano de altísima fidelidad que permite generar predicciones rápidas en segundos —durante un tsunami real— utilizando clústeres de GPU modestos. Los investigadores afirmaron que esta capacidad podría transformar fundamentalmente el futuro de los sistemas de alerta temprana y salvar vidas.

Desarrollado en colaboración con el Instituto Oden de la Universidad de Texas en Austin (UT Austin) y el Instituto Scripps de Oceanografía de la Universidad de California en San Diego (UC San Diego), el «gemelo digital» del tsunami resultante modela los efectos del movimiento sísmico del fondo marino utilizando datos de sensores de presión en tiempo real y simulaciones avanzadas basadas en la física. Este sistema dinámico, basado en datos, puede inferir el impacto del terremoto en el fondo oceánico y pronosticar el comportamiento del tsunami en tiempo real, incluyendo la cuantificación de la incertidumbre.

«Este es el primer gemelo digital con este nivel de complejidad que se ejecuta en tiempo real», afirmó Tzanio Kolev, matemático computacional del LLNL y coautor del artículo. «Combina la simulación directa a escala extrema con métodos estadísticos avanzados para extraer predicciones basadas en la física a partir de datos de sensores a una velocidad sin precedentes».

Al aprovechar la supercomputadora de exaescala El Capitan de Hewlett Packard Enterprise/AMD de LLNL en el paso de precomputación fuera de línea, el equipo pudo resolver un problema inverso bayesiano de mil millones de parámetros en menos de 0,2 segundos, prediciendo con precisión las alturas de las olas del tsunami a una asombrosa velocidad de 10 mil millones de veces mayor que los métodos existentes.

Los investigadores afirmaron que esta capacidad podría mejorar radicalmente la respuesta a emergencias y salvar vidas, constituyendo la base de los sistemas de alerta temprana de próxima generación. En el caso de eventos cercanos a la costa, como un futuro terremoto de magnitud 8.0 o superior en la Zona de Subducción de Cascadia, en el noroeste del Pacífico estadounidense, las primeras olas destructivas podrían alcanzar la costa en 10 minutos, lo que dejaría poco tiempo para la evacuación, según los investigadores.

arXiv (2025). DOI: 10.48550/arxiv.2504.16344

Los sistemas convencionales de alerta de tsunamis suelen basarse en datos sísmicos y geodésicos para inferir la magnitud y la ubicación de los terremotos, pero suelen emplear modelos simplistas que no captan la complejidad de las rupturas de fallas, lo que puede generar falsas alarmas o alertas peligrosamente tardías. En cambio, el enfoque del equipo utiliza datos de sensores de presión del fondo marino y resuelve un modelo físico completo de la propagación de ondas acústicas-gravitacionales en el océano en tiempo récord.

A medida que las redes de sensores del fondo marino, incluida la detección acústica distribuida, se vuelven más comunes en las costas propensas a terremotos y la infraestructura computacional continúa mejorando, el equipo ve un camino claro para implementar el enfoque en futuros sistemas de alerta de tsunamis, lo que resultará en alertas de emergencia más rápidas, más inteligentes y más confiables.

«Este marco representa un cambio de paradigma en cómo pensamos acerca de los sistemas de alerta temprana», dijo el autor principal del estudio, Omar Ghattas, profesor de ingeniería mecánica y profesor principal del Instituto Oden en UT-Austin.

Por primera vez, podemos combinar datos de sensores en tiempo real con modelado físico completo y cuantificación de incertidumbre, con la rapidez suficiente para tomar decisiones antes de que un tsunami llegue a la costa. Esto abre la puerta a sistemas de respuesta a emergencias verdaderamente predictivos y basados en la física para una variedad de peligros naturales.

En el corazón del sistema se encuentra MFEM, la biblioteca de elementos finitos de código abierto de LLNL, que permite simulaciones escalables y aceleradas por GPU de muchos fenómenos físicos, incluida la propagación de ondas acústicas-gravitacionales en el océano.

Al ejecutar estas simulaciones en 43.520 APU de El Capitán, MFEM realizó la fase que requirió mayor esfuerzo computacional (resolver las ecuaciones de ondas acústicas y de gravedad para precalcular los mapeos entre el movimiento del fondo oceánico y los datos de los sensores) utilizando unos asombrosos 55,5 billones de grados de libertad, rompiendo el récord anterior para la simulación de elementos finitos de malla no estructurada más grande.

«Los métodos de alto nivel de MFEM y su compatibilidad con GPU, desarrollados en el marco del programa ASC del LLNL y el Proyecto de Computación a Exaescala del Departamento de Energía (DOE), permitieron escalar a la máquina completa», afirmó Kolev. «Esta fue una demostración pionera de cómo podemos usar esa potencia no solo para el rendimiento bruto, sino también para tomar decisiones cruciales para la misión en muchas aplicaciones basadas en MFEM».

Según Kolev, una vez que se completen los precálculos masivos, los pasos en línea para inferir el movimiento del fondo marino y pronosticar las alturas de las olas del tsunami en tiempo real se pueden realizar en clústeres de GPU mucho más modestos, ya que los algoritmos subyacentes están diseñados para mapearse bien en las GPU.

«Este trabajo es importante porque demuestra que podemos resolver un problema inverso de enorme magnitud, no para 10 o 15 variables, sino para millones, o incluso miles de millones, de variables, con gran rapidez», afirmó Kolev. «Antes, se obtenía un modelo rápido e inexacto, o un modelo de física completa que tardaba horas o días. Ahora demostramos que podemos lograr ambas cosas —precisas y rápidas— utilizando matemáticas basadas en principios y computación moderna».

Kolev dijo que el marco de inversión bayesiana no es una «capacidad única» limitada a los tsunamis y podría aplicarse a una amplia gama de sistemas complejos, desde el seguimiento de incendios forestales en tiempo real y el seguimiento de contaminantes del subsuelo hasta el pronóstico del clima espacial e incluso aplicaciones de inteligencia donde se necesitan decisiones rápidas basadas en datos.

Más información: Stefan Henneking et al., Inferencia bayesiana en tiempo real a escala extrema: Un gemelo digital para la alerta temprana de tsunamis aplicado a la zona de subducción de Cascadia, arXiv (2025). DOI: 10.48550/arxiv.2504.16344

Nota editorial:

Este artículo ha sido elaborado con fines divulgativos a partir de información pública y fuentes especializadas, adaptado al enfoque editorial del medio para facilitar su comprensión y contextualización.